はじめに

2020年8月23日~28日の間で開催されたECCV(EUROPEAN CONFERENCE ON COMPUTER VISION:https://eccv2020.eu/)で採択されたNVIDIAの「画像生成モデル」に関する論文についてご紹介します。

Meta-Sim 2

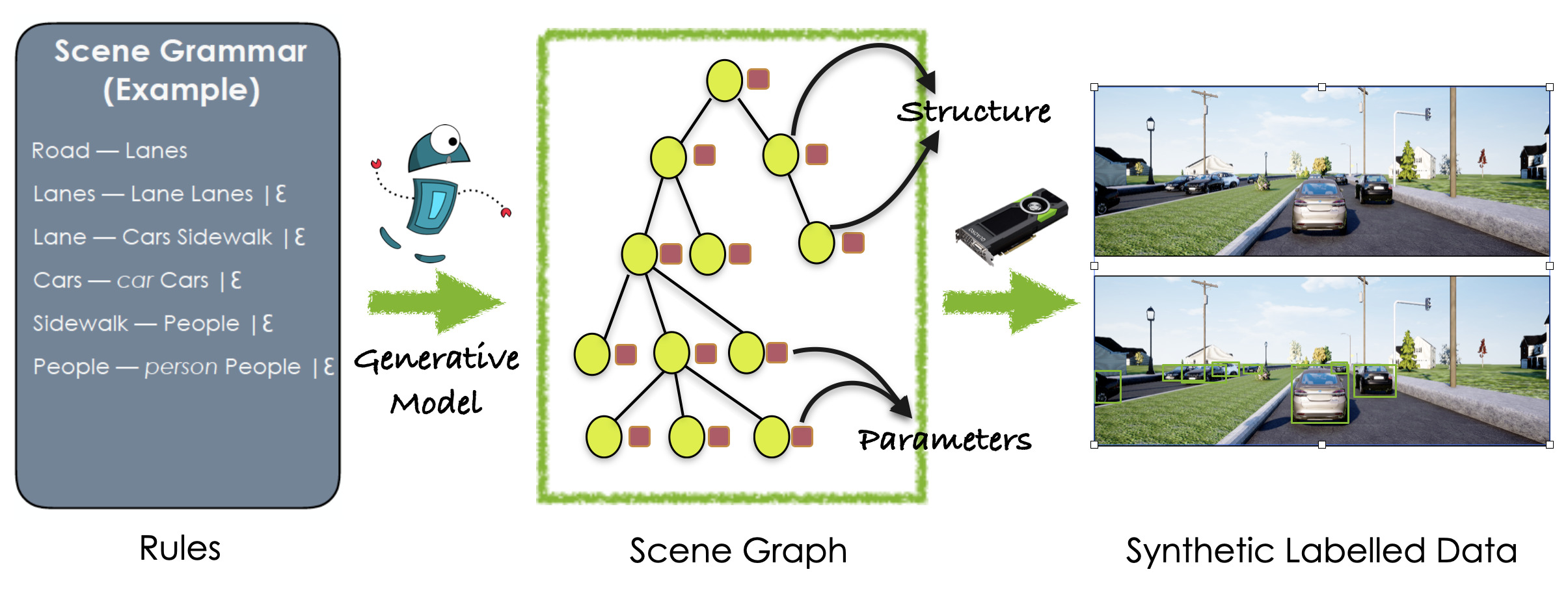

Unsupervised Learning of Scene Structure for Synthetic Data Generation

合成データ生成に対するシーン構成の教師なし学習

https://nv-tlabs.github.io/meta-sim-structure/

・NVIDIAが3DCGを生成する教師なしモデルを発表。

・従来までは職人芸の域にあったパラメータの調整を自動化することを目指した。

・強化学習を利用して特徴空間を学習することで、シーンの構造を学習することに成功した。

NVIDIA公式紹介ショートビデオ

説明

「プロシージャルモデリング(Procedural Modeling)」とは、プロシージャル(数式処理の組み合わせ)を利用して3DCGのモデル(物体)を生成することを指します。プロシージャルとは、もともと「手抜き型」や「手続き型」という意味で、数式を用いて何らかの法則に従ってあらかじめ準備しておいた処理を行います。

プロシージャルモデルは、グラフィックスやゲームなどのシーン合成で広く利用されてきました。現在では、機械学習のための(ラベル付き)合成データセットの作成などに広く利用されています。

NVIDIAによると、これまでリアルで多様なシーンを生成するためには、プロシージャルモデルを制御するいくつかのパラメータを専門家が慎重に調整する必要がありました。これらのパラメータは、生成されるシーンの構造(例:シーン内に何台の車があるかなど)や、オブジェクトを有効な構成に配置するためのパラメータを制御しています。

Meta-Simでは、教師なし手法で実画像のターゲットコレクションを与えられたパラメータを自動的にチューニングすることを目指しています。Meta-Sim2では、パラメータに加えてシーンの構造を学習することを目的としていますが、これは離散的な性質のために難しい問題とされています。Meta-Sim2では、与えられた確率的シーン文法からルール展開を順次サンプリングする学習を行っています。Meta-Sim2モデルではモデルを訓練するために強化学習を使用し、訓練を成功させる鍵となる合成画像とターゲット画像の間の特徴空間の発散を設計しています。

実際の運転データセットでの実験では、教師なしで、実画像の中のオブジェクトの頻度などの離散的な構造統計情報をキャプチャするデータを生成するための学習に成功することが示されています。また、このことが、他のベースラインシミュレーション手法と比較して、データセットで訓練された物体検出器の性能の向上につながることを示しています。

NVIDIA公式紹介フルビデオ