はじめに

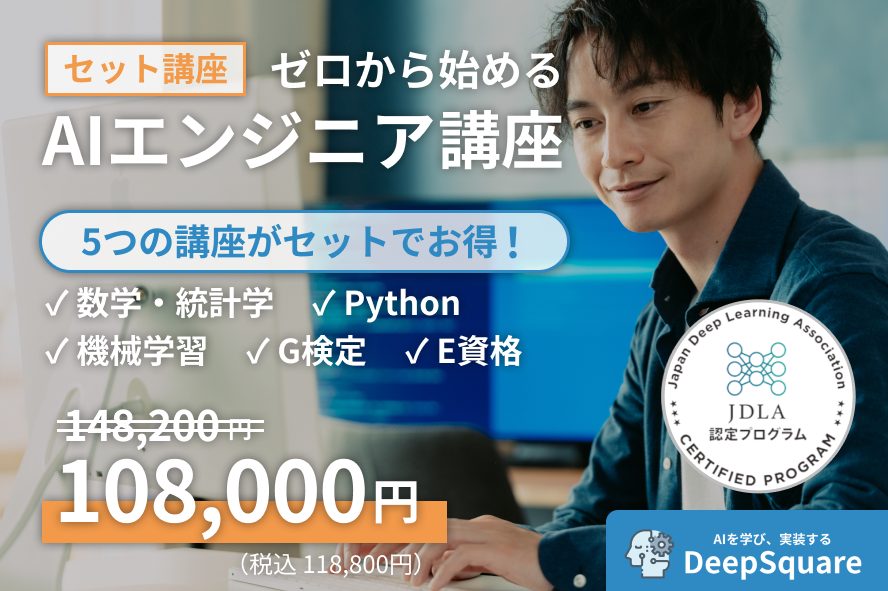

Facebookが視覚障がい者や視覚に困難がある人のために画像情報を説明するサービスAAT(Automatic alternative text)を改良しました。

Facebook

How Facebook is using AI to improve photo descriptions for people who are blind or visually impaired

https://ai.facebook.com/blog/how-facebook-is-using-ai-to-improve-photo-descriptions-for-people-who-are-blind-or-visually-impaired/

AAT

Facebookは2016年よりAAT(Automatic alternative text)を提供してきました。これは視覚障がいなどの理由で画像を直接視覚でとらえられないひとのためのサービスで、代替テキストを音声で伝えるものです。本来は画像にディスクリプションがある場合は、それを音声で伝えることがベストですが、画像のほとんどは説明文などがないため、汎用的に利用するために画像から得られる情報を利用してAIが説明文章を生成しています。

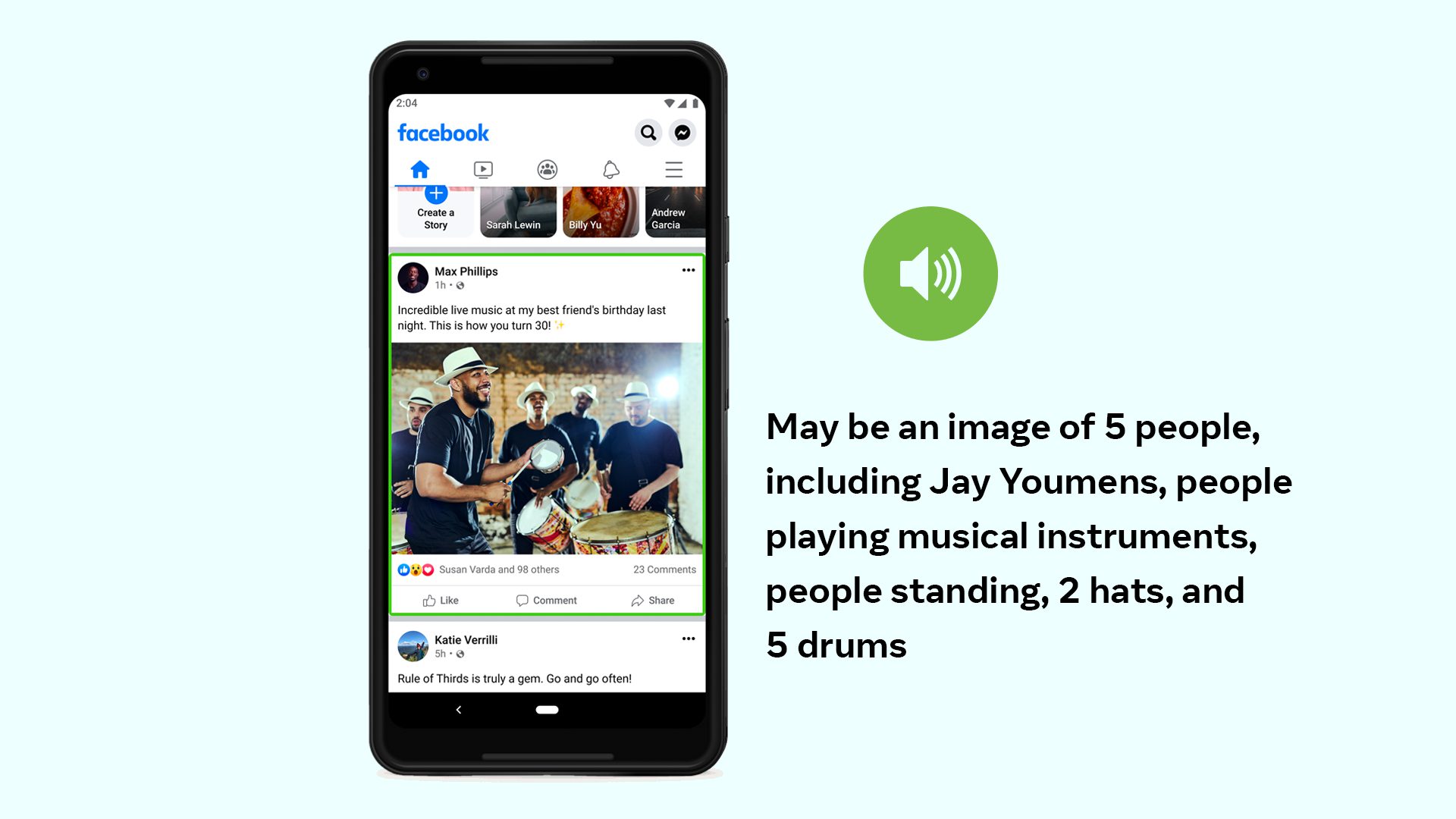

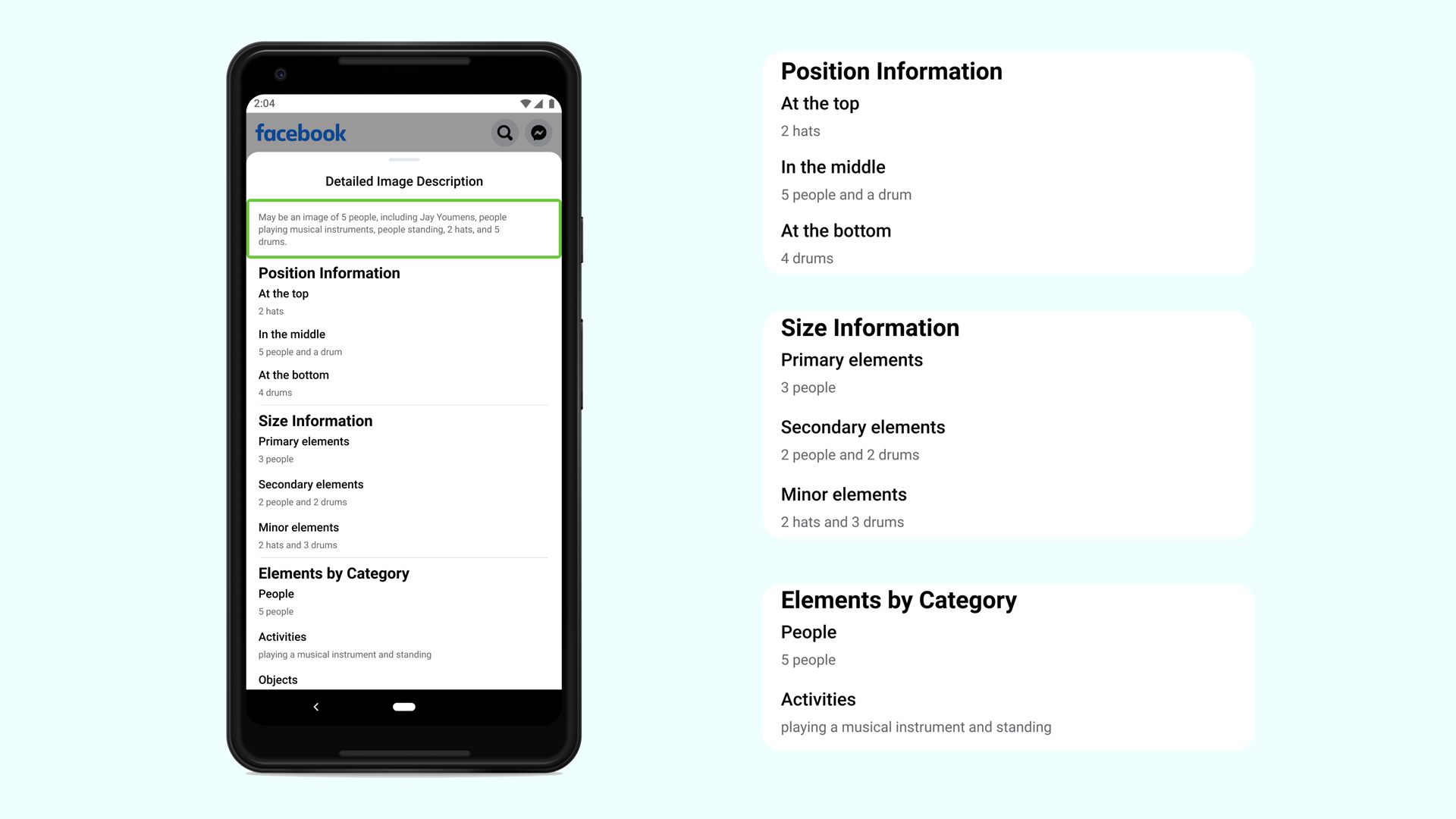

今回、AATに新たな改良がくわえられたことで、従来の10倍の概念(1200概念)を表現することができるようになり、より細かい情景を捉えることが可能になりました。また、はじめて物体の位置情報と相対的な大きさの情報を利用することも可能になりました。このことで、前景にいる人と後景にいる人の違いなどを把握した説明文が可能となります。

AATの具体的な改良

AATを改良するにあたり、人間の手でラベル付けされたデータを利用することの限界がはっきりしました。人間の手でラベル付けをすると費用がかかるため、利用できるデータ量が限られてしまうという問題点があります。そのため、今回の改良では、弱教師学習として数十億のインスタグラムの写真とそれらに付随しているハッシュタグを利用しました。なお、地域差が出ないよう、すべての地域の画像からデータがサンプリングされるようにモデルを微調整し、多くの言語でハッシュタグの翻訳を使用しました。また、文化差や性差などの偏りから生じるバイアスなどが軽減するように設計されています。

より詳細の伝達

利用者にどれくらいの情報が必要なのかをも調査しています。そこからわかったことは、友達や家族からの画像に対して、人々はより情報を欲しがるということです。そのため、新たに情報量を選択できるようにしています。

まとめ

OpenAIのCLIPがより大規模なデータを扱って自然言語教師型の画像分類を可能にしました。今回のFacebookの改良も大規模データの利用を重視した改良だといえます。Facebookのサービスが改良することは利用者として歓迎できる一方で、今後大規模データが扱える企業しか生き残れない危険性もあります。開発企業の寡占が進むことも懸念されます。