Brain-inspired replay for continual learning with artificial neural networks

https://www.nature.com/articles/s41467-020-17866-2

概要

マサチューセッツ大学アマースト校とベイラー医科大学の研究チームが「リプレイ」として知られる人間の脳の記憶メカニズムからインスピレーションを得て、「major, long-standing obstacle to increasing AI capabilities(AI向上における長年の障害)」とされてきたディープニューラルネットワークの「忘却」にうまく対処したと報告しました。

詳細

AIの進歩を阻んでいたことのひとつに、ディープニューラルネットワークが新たな学習をすると、以前の状態を忘却してしまうという問題がありました。

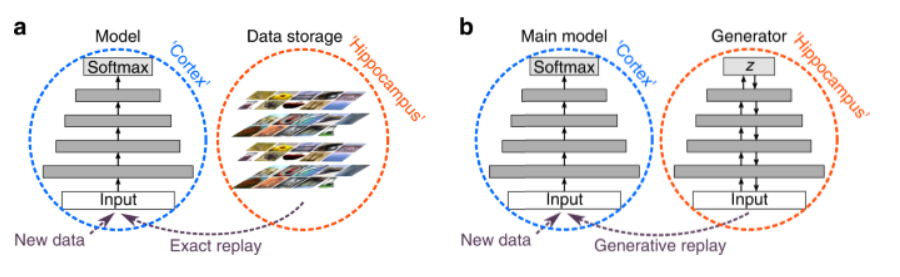

解決策の一つとしては、過去の例を保存し、新しい学習をする際に再度過去の例を学習することがすでに提案されています。しかし、すでに学習したものを絶えず再学習の対象にすることは非常に効率が悪く、また保存する必要のあるデータもすぐに膨大なものになるという問題が指摘されています。

そこで、研究チームは人間が生涯を通じて継続的に情報を蓄積することができるという点に着目しました。記憶を忘却から保護すると信じられている脳の重要なメカニズムは、それらの記憶を表す神経活動パターンの再生であると研究チームはしています。

特に今回の研究につながった重要な洞察は「脳内での記憶の再生ではデータが保存されていないこと」だとしています。脳は、詳細な記憶を思い出しているのではなく、より抽象的なレベルで記憶の表現を脳内で生成しているということです。そこで、ネットワークを脳のように以前に学習したものを高い抽象度の表現として生成することで問題に対処しました。学習のたびに再度高い抽象度の表現を生成させるだけで、記憶を維持しているような状況になるとしています。

例えば、生成的リプレイを備えたネットワークでは、最初に猫を犬から分離し、次にクマをキツネから分離することを学習した場合、特に訓練を受けていなくても、猫とキツネを区別することができるとしています。特に、システムが学習するほど、新しいタスクの学習が上手くなるとしています。

実際のモデル内部では、ネットワーク自体のcontext-modulated feedback connectionsによって生成される内部表現または非表示表現が再生されることになります。データを保存することなく、実験ではベンチマークで最先端のパフォーマンスを実現したとしています。

参照URL

The Brain’s Memory Abilities Inspire AI Experts in Making Neural Networks Less ‘Forgetful’

https://www.umass.edu/advance/brains-memory-abilities-inspire-ai-experts-making-neural-networks-less-forgetful

Gido M. van de Ven, Hava T. Siegelmann, Andreas S. Tolias. Brain-inspired replay for continual learning with artificial neural networks. Nature Communications, 2020; 11 (1) DOI: 10.1038/s41467-020-17866-2