はじめに

プリンストン大学が、さまざまな種類の障害や制約が想定される未知の環境下でのロボットの安全性とパフォーマンスの保証に関する機械学習手法を発表しました。

Machine learning guarantees robots’ performance in unknown territory

https://engineering.princeton.edu/news/2020/11/17/machine-learning-guarantees-robots-performance-unknown-territory

論文

PAC-Bayes control: learning policies that provably generalize to novel environments

https://journals.sagepub.com/doi/10.1177/0278364920959444

概要

ロボット工学において、近年適応性の高いロボットのを開発するために機械学習手法は注目されてきました。しかし、機械学習に基づくロボット制御アルゴリズムは、トレーニングデータに過剰適合するリスクがあり、トレーニングされたものとは異なる入力に遭遇すると、アルゴリズムの効果が低下する可能性があります。

今回、研究チームはロボット制御ポリシーをトレーニングするために利用可能なツールのスイートを拡張し、新しい環境で動作するロボットの成功と安全性を定量化することで、この課題に対処しました。

詳細

研究チームは他の分野の機械学習フレームワークをロボットの移動と操作の分野に適応させました。今回の研究では、一般化理論(通常、自動画像タグ付けなど、単一の入力を単一の出力にマッピングするコンテキストで使用されます)に注目しています。研究で提言されている新しい方法は、学習されていない設定でのロボットのパフォーマンスを保証するというより複雑なタスクに一般化理論を適用した最初の方法の1つであるとしています。そのため、これまでの他のアプローチはより制限的な仮定の下でそのような保証を提供しましたが、チームの方法は新しい環境でのパフォーマンスに関してより広く適用可能な保証を提供しているとしています。関連した3つの論文がまとめて発表されています。

機械学習フレームワークを適用するための原理実証である最初の論文では、研究チームは段ボールのシリンダーが点在する長さ60フィートの廊下を飛行するときに、ドローンの障害物回避を評価することによって、この手法を検証しました。ドローンの制御ポリシーの保証された成功率は88.4%であり、20回の試行のうち18回(90%)で障害を回避しました。ただし、この成功率は実際に応用する場合には問題があることを研究チームも自覚しており、今後の発展する必要があるとしています。

研究チームは、そのためロボット制御ポリシーを実際の展開に必要な保証に近づけるための追加の改良点を検討しました。次の論文では、人間の「専門家」がシミュレートされたロボットを手動で誘導してさまざまな物体を拾ったり、障害物のあるさまざまな空間を移動したりすることでトレーニングデータを提供する模倣学習を使用しました。このアプローチにより、機械学習ベースの制御ポリシーの成功を向上させることができます。

トレーニングデータを提供するために、3Dコンピューターマウスを使用して、さまざまなサイズ、形状、素材の飲用マグカップをつかんで持ち上げるシミュレーションロボットアームを制御しました。他の模倣学習実験では、腕がテーブルを横切って箱を押すことや、家のような環境で家具の周りを移動する車輪付きロボットのシミュレーションが行われました。

研究チームは、マグカップをつかむタスクとボックスを押すタスクから学んだポリシーを、ハンドルを持たずに2本の指のようなグリッパーの間でリムをつかむことで25種類のマグカップを拾うロボットアームに展開しました。ボックスプッシュの例では、ポリシーは簡単なタスクで93%、難しいタスクで80%の成功を達成しました。

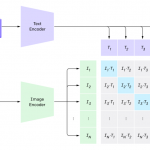

3番目の論文では、飛行ロボットまたは歩行ロボットがさまざまな環境で計画された一連の動作を実行することを保証する視覚ベースのプランナーの開発が行われました。計画された動きの制御ポリシーを生成することは、「規模」という新しい問題をもたらしました。数百ではなく数千の次元でビジョンベースのポリシーを最適化する必要があります。

論文における戦略の重要な側面は、モーションプリミティブの使用でした。このポリシーでは、各動作にトルクや速度を指定するのではなく、たとえば、ロボットに直進または旋回するように指示しています。可能な行動のスペースを狭めることは、計画プロセスをより計算的に扱いやすくする、と述べています。

この研究では、脚式ロボットは目に見えないテスト環境で80%の成功率を達成しました。

研究チームは今後ポリシーの保証をさらに改善するとともに、実験室の実際のロボットでのポリシーのパフォーマンスを評価するために取り組んでいくとしています。

Anirudha Majumdar, Alec Farid, Anoopkumar Sonar. PAC-Bayes control: learning policies that provably generalize to novel environments. The International Journal of Robotics Research, 2020; 027836492095944 DOI: 10.1177/0278364920959444