はじめに

米MITが、ニューラルネットワークが敵対的入力に対抗するために、はじめて強化学習を用いて、入力データを全面的に受け入れるのではなく「懐疑」的に選別できるモデルを発表しました。

Algorithm helps artificial intelligence systems dodge “adversarial” inputs

https://news.mit.edu/2021/artificial-intelligence-adversarial-0308

〇論文

Certifiable Robustness to Adversarial State Uncertainty in Deep Reinforcement Learning

https://ieeexplore.ieee.org/document/9354500/metrics

概要

入力されるデータは完璧に現実を反映しているものではなく、意図せず不完全になってしまったデータや敵対的意図から誤っているデータが入力される危険性があります。完璧なデータのみを想定したモデルでは、それらのデータに対応できず不適切な結果を出力してしまうため対策が求められていました。

今回、MITが強化学習を利用して、入力されるデータの不確実性を判断したうえで出力を行うモデルを作成しました。

詳細

これまでの問題点

完璧なデータが入力される場合、モデルはデータを素直に計算していくだけで求められる結果を出力することができます。しかし、実際に入力されるデータは欠損、もしくは部分的に変化していたり、場合によっては敵対的な意図をもって変更が加えられていることがあります。そのため、入力データを素直に利用するだけでは現実世界では対応できないことが指摘されてきました。

教師あり手法の限界

研究チームは、はじめ教師あり学習で敵対的な入力に対する防御法を学習させようとしました。

しかし、考えられるすべての画像変更を実行することは、計算が網羅的であり、衝突回避などの時間に敏感なタスクに正常に適用することは困難であることが明らかになりました。さらに、既存の方法では、ネットワークのロバスト性が低く、変更された猫の画像に家やホットドッグのラベルが付けられている場合、使用するラベルや実行するアクションも識別されません。

そのため、強化学習を利用する手法が開発されました。

CARRL:Certified Adversarial Robustness for Deep Reinforcement Learning

ディープニューラルネットワークに強化学習を組み合わせて不安的な入力データに対応する、CARRL(Certified Adversarial Robustness for Deep Reinforcement Learning)を開発しました。

研究チームは不安定、もしくは敵対的な入力に対して「証明可能なロバスト性」をもたらすために強化学習を利用したはじめての例だとしています。

CARRLは、ディープQネットワーク、通称DQNと呼ばれる強化学習アルゴリズムを利用して行われています。

このアプローチでは、単一のドットを含む画像などの入力を受け取り、敵対的な影響、または実際にはドットの周囲にある可能性のある領域を考慮します。この領域内のドットのすべての可能な位置は、DQNを介して供給され、最悪の場合に最適な報酬をもたらす関連アクションを見つけるように学習していきます。

実際には、実行中に状態アクション値の保証された下限を計算して、可能性がある敵対的入力またはノイズによって考慮される入力空間における最悪の場合の偏差のもとで最もロバストなアクションを識別および選択します。

なお、不確実性を推定し始めると、行動できなくなってしまうことがあるため、行動ができる範囲の不確実性の範囲を抑える必要がでてきます。たとえば、モデルは、エージェントが高い報酬を達成して目的地に到達することを可能にする、より小さな偏差または不確実性の領域を考慮して行動することになります。

実験

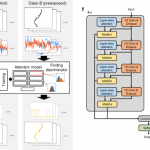

実験では、2人のプレーヤーが画面の両側でパドルを操作してボールを前後に通過させるビデオゲームPongを使用したテストが行われました。ボールを実際よりもわずかに引き下げる「敵対的」入力が行われました。敵対的入力の影響力が増すにつれて、CARRLが標準的なテクニックよりも性能が良くなることを発見しました。

測定値が正確に信頼されるべきではなく、ボールが特定の領域内のどこにでもある可能性があることがわかっている場合、モデルに最悪の場合の偏差でもボールを打つことを確実にするために、その領域の中央にパドルを置く必要があることを学習させます。

Pongのゲームで、完璧な測定では、標準的な深層学習アルゴリズムがほとんどのゲームに勝つことができることを示しています(左)。 しかし、測定値がボールの位置を数ピクセル(中央)シフトする「敵対的入力」の影響を受けるシナリオでは、コンピューターは標準のアルゴリズムを簡単に打ち負かします。新たに開発されたCARRL(右)は、ボールがどこにあるかを正確に知らなくても、敵対的な攻撃や測定値の操作を処理し、コンピューターに勝つことができます。

まとめ

ニューラルネットワーク、人工知能が利用される機会が多くなるにつれ、そのセキュリティ上の不安定さが問題視されてきました。自動運転時にAIを混乱させるような入力は既に明らかになっており、実用化のハードルのひとつになっています。今回開発されたモデルは、汎用的な利用が可能であるとされているため、今後組み込まれていくことでより安全なモデルになり、より利用が安全な形で普及していくことが期待されます。