はじめに

ディープラーニングを用いたモデルは画像分類や音声認識などさまざまなタスクで高い精度を達成し、現在実際に現場で利用されています。しかし、その一方でディープラーニングがなぜそれだけ高い精度を出すことができているのか、不透明であるというブラックボックス問題を抱えたままでもあります。今回、デューク大学の研究チームは、ディープラーニングモデルの背後にある推論プロセスを変更することにより、ネットワークのトラブルシューティングを改善したり、ネットワークが信頼できるものであるかどうかを理解することができるようになったと発表しました。

ACCURATE NEURAL NETWORK COMPUTER VISION WITHOUT THE ‘BLACK BOX’

https://today.duke.edu/2020/12/accurate-neural-network-computer-vision-without-black-box

論文

Concept whitening for interpretable image recognition

https://www.nature.com/articles/s42256-020-00265-z

現状の問題

自動車の自動運転から医療診断まで幅広い分野のモデルがディープラーニングで構築されており、すでに実用という意味では問題なく利用できる段階に達しているといえます。しかし、「なぜそうなるのか」という説明力がディープラーニングには欠けているという問題があります。これはブラックボックス問題としてディープラーニングが利用されるようになってから常に議論されている問題ではありますが、抜本的な解決方法はいまだに示されていません。そのため、実用的な精度に達していても、生死や人生を大きく左右しかねない判断には利用されることはほぼないという現実があります。

論文概要

現在、ディープラーニングに説明力を求めるモデルの多くは、画像を特定する主要な特徴またはピクセルを指摘することにより、事後にコンピュータビジョンシステムを正しい答えに導いた理由を明らかにしようとします。しかし、この方法は、ネットワークの理由を明らかにするというよりは、どこを探索していたのかということを明らかにしているだけで本質的に理由を説明していることにはならないのではないかをデューク大学の研究チームは考えました。

そのため、デューク大学は事後ベースでネットワークの意思決定を説明しようとするのではなく、意思決定の途中で概念についての理解を表現するように学習させることによって、ネットワークの意思決定メカニズムを覗き見するようにしました。このことでネットワークのレイヤー内で構築されている概念を解読することができます。

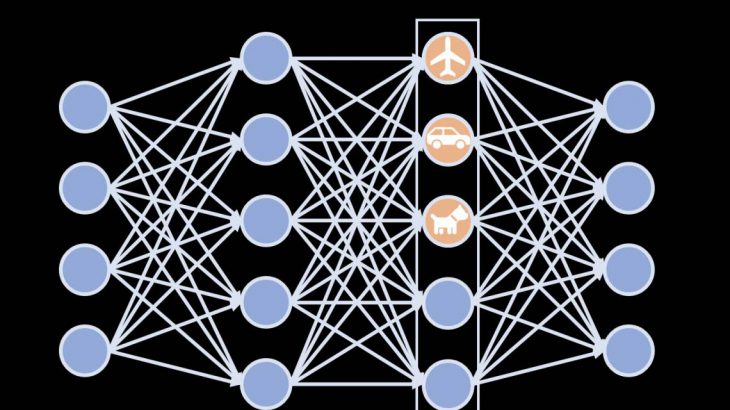

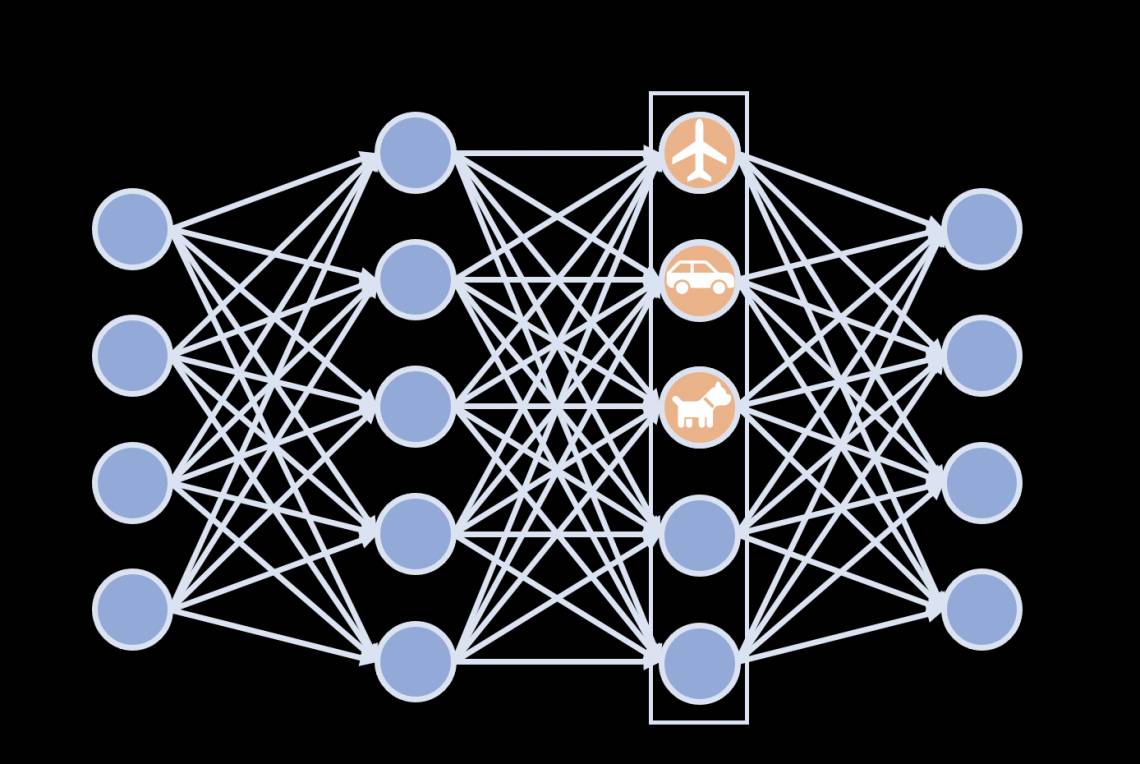

今回の方法では、ニューラルネットワークの特定の層を新たにConcept Whitinig(CW)と呼ばれる層に置き換えます。この層では、人間が理解できる概念(例えば、本や自転車といった物体から、金属といった性質、冷たいなどの形容を含みます)に応じて発火するような単一のニューロンのみで構成されています。このことで、どのような情報がニューラルネットワーク内で流れているのかを知ることができます。

デューク大学の研究チームによる動画説明

成果

この方法を用いることで、ニューラルネットワークが何に基づいて判断しているのかを人間の概念ベースで確認することができます。例えば、夕暮れどきの写真は、初期段階では色や「暖かい」という概念と結びついており、後半では「飛行機」という概念を利用していることがわかりました。また実験では、ディープラーニングモデルの問題点も明らかにしました。皮膚がんを検出するように訓練されたニューラルネットワークが、研究者が意図していないトレーニングラベルの特徴を学習してしまっていることを発見しました。このことは、ブラックボックスモデルに妄信的な信頼を置くべきではないことを示しているとしています。

Zhi Chen, Yijie Bei, Cynthia Rudin. Concept whitening for interpretable image recognition. Nature Machine Intelligence, 2020; 2 (12): 772 DOI: 10.1038/s42256-020-00265-z