Attentive Normalization

https://www.ecva.net/papers/eccv_2020/papers_ECCV/papers/123620069.pdf

概要

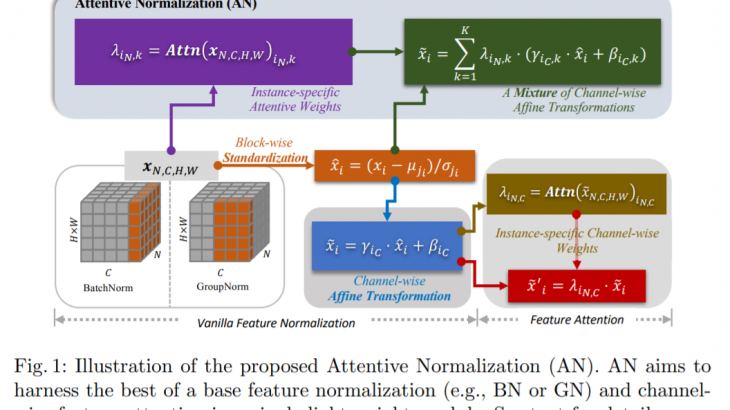

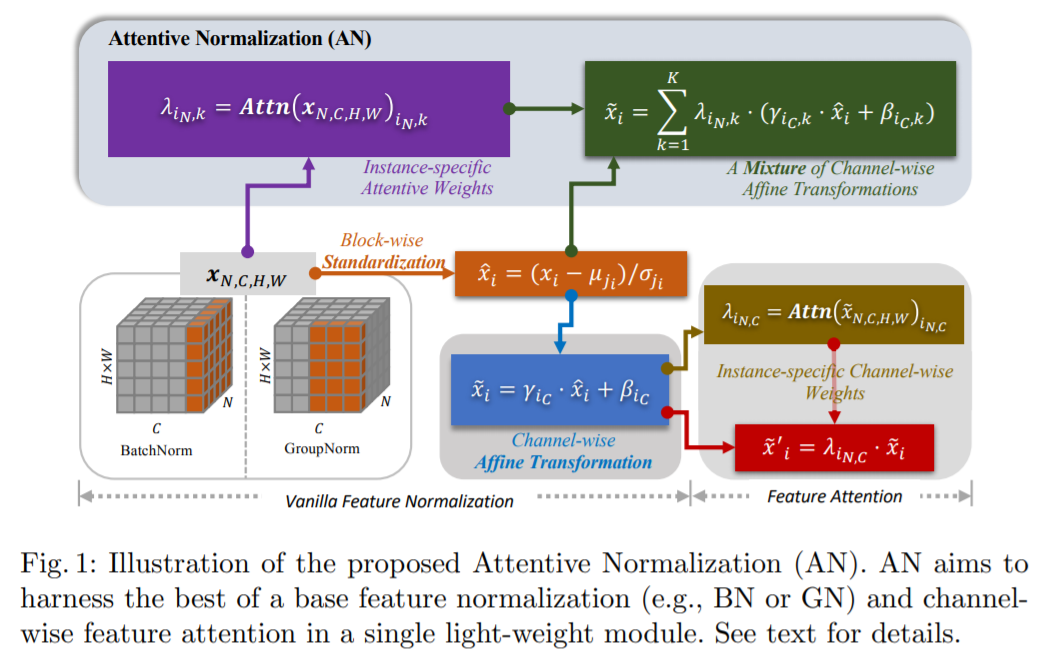

ノースカロライナ州立大学の研究チームが、正規化とAttentionモジュールを1つのモジュールに組み合わた、attentive normalization(AN)を開発しました。このハイブリッドモジュールは、少量の追加計算コストのみで、システムの精度を大幅に向上させます。今回提案されたANは、広く使用されているSqueeze-and-Excitation(SE)モジュールの強力な代替手段になるとされています。

詳細

●アイディア

正規化は学習に対して重要な要素であり、またAtteintionモジュールはネットワークが特定のタスクを達成するために生データから学習した特徴を強調することを助けるためにも同様に重要です。しかしながら、研究チームによると、従来は両者は別々に扱われており、今回の研究では組み合わせることでより効率的かつ効果的になることがわかったとしています。

●テスト

ANモジュールをテストするために、一般的な4つのニューラルネットワークアーキテクチャ(ResNets、DenseNets、MobileNetsV2、AOGNets)に接続し、2つのベンチマーク(ImageNet-1000分類ベンチマークとMS-COCO 2017オブジェクト検出およびインスタンスセグメンテーションベンチマーク)でテストしました。

結果は、両者のベンチマークテストにおいてすべてのモデルがパフォーマンスを向上させることがわかったとしています。ImageNet-1000のトップ1の精度は0.5%から2.7%へ向上しました。また、平均精度(AP)の精度はMS-COCOのバウンディングボックスで最大1.8%、セマンティックマスクで2.2%向上しました。

●異なるドメイン間の転移学習の促進

ANのもう1つの利点は、異なるドメイン間でより良い転移学習を可能にすることにあると研究チームは主張しています。実験では、ImageNetで事前学習されたネットワークをfine-tuiningし、MS-COCOベンチマークでテストした際、パフォーマンスの向上が確認されています。

●ソースコード

Attentive Normalizationのソースコード

(AOGNet-v2の一部として表記されています)

https://github.com/iVMCL/AOGNet-v2