はじめに

OpenAIが新たに文章から画像を生成するモデルDALL·Eを発表しました。

これまでOpenAIは、普段の言語によって多様なテキストを生成することが可能であるGPT-3や、高い精度で画像を生成することができるImage GPTを開発してきました。

今回のDALL・Eは両者の研究を生かしたもので、普段の言語で画像を簡単に生成することが可能であることを示しました。詳細については将来的に論文で発表するとのことですが、ブログを通して概要が明かされたのでご紹介します。なお、引用した画像はすべて下記OpenAIブログより引用しています。

概要

DALL・Eは、120憶のパラメータをもつGPT-3を説明文から画像を生成するように学習させたものです。画家のサルバドール・ダリとピクサー映画WALL・Eに由来して名付けられそうです。動物やオブジェクトの擬人化されたバージョンの作成、関連のない概念の妥当な方法での組み合わせ、テキストのレンダリング、既存の画像への変換の適用など、さまざまな表現を普段の言語で簡単に、しかも高い精度で実現することができます。

DALL・Eのようなモデルが与える特定の作業プロセスや職業への経済的影響、モデル出力の偏りの可能性、このようなテクノロジーによって暗示される長期的な倫理的課題などの社会的問題にどのように関連しているかなどについては今後分析する予定とのことです。

モデル構造

DALL・Eは、GPT-3と同じTransformerモデルで構築されています。違いは、最大1280個のトークンを含む単一のデータストリームとしてテキストと画像の両方を受け取る点にあります。受け取ったデータを自己回帰的にモデル化するデコーダーのみのTransformerです。実際のモデルには、64個のSelf-Attention層があり、各画像トークンとテキストトークンの関係性を学習していくことになります。

トークンは、個別の語彙からの任意の記号として機能します。人間の場合、各英語の文字は26文字のアルファベットからなるトークンですが、 DALL・Eの語彙には、テキストと画像の両方の概念のトークンが必要となります。具体的には、各画像の説明文は、ボキャブラリーサイズが16384で最大256個のBPEエンコードトークンを使用して表され、画像は、ボキャブラリーサイズが8192の1024個のトークンを使用して表されます。

画像はトレーニング中に256×256の解像度に前処理されます。 VQVAEモデルと同様に、各画像は、連続「緩和relaxation」を使用して事前トレーニングした離散VAEを使用して、離散潜在コードの32×32グリッドに圧縮されます。「緩和」を使用したトレーニングでは、明示的なコードブック、EMAの損失、またはデッドコードの復活のようトリックが不要で、より大きなボキャブラリーサイズにスケールアップできます。

性能

DALL・Eは様々なことが可能です。ここではブログで紹介されているものを簡単にご紹介します。

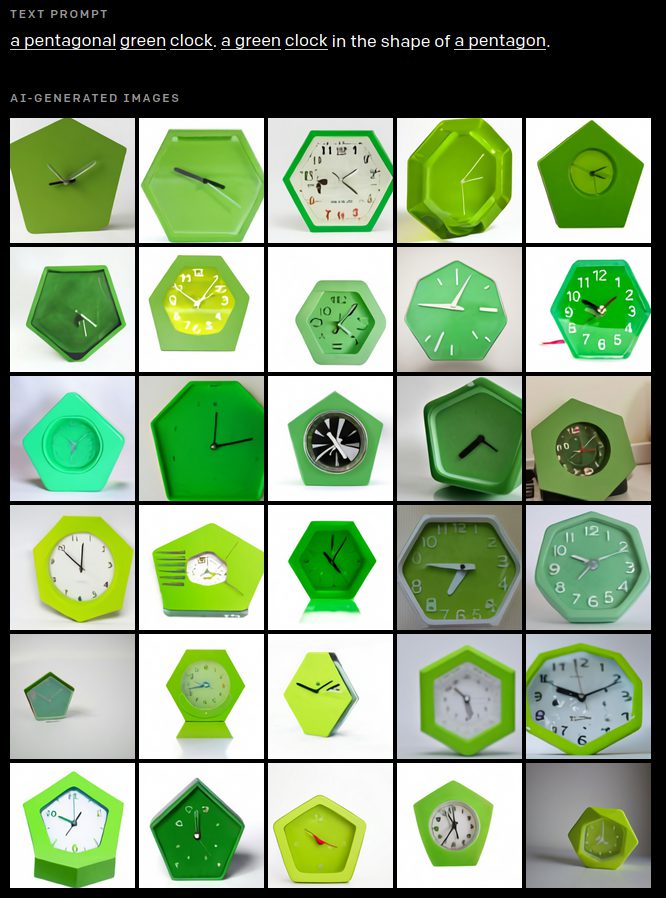

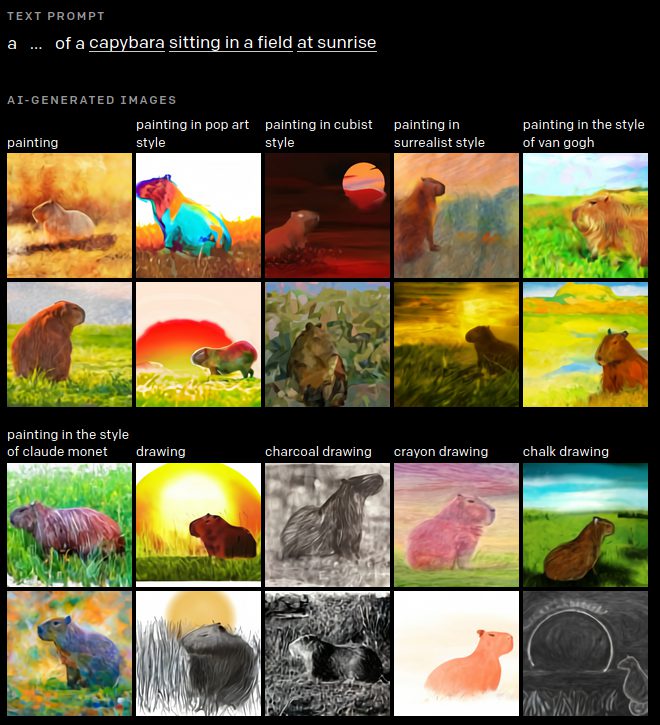

・属性・形状の変更

形や色、材質などを指定することで変更することができます。ただし、オブジェクトによってはうまく対応できないことがあるようです。

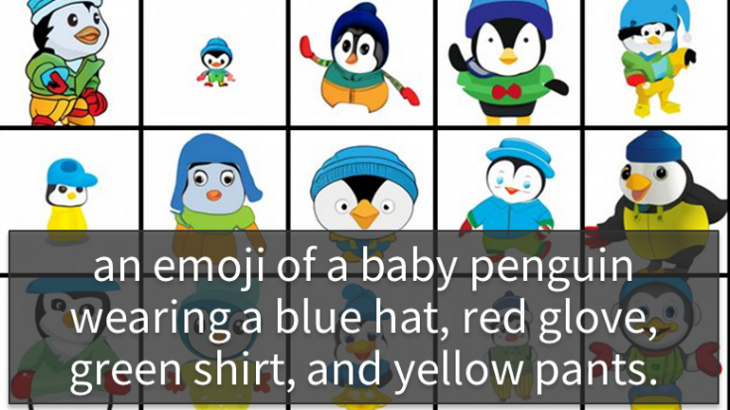

・複数オブジェクトの描写

複数のオブジェクトもきちんと描写できます。オブジェクト毎に求められる要素に対応しています(サンプルでは、要請された通りの服装になることができています。

)。ただし、表現によっては対応できない場合があるということです。

・遠近法と三次元性の視覚化

物体の外部情報などをうまくとらえることができていることがわかります。また、オブジェクトの骨格などを捉えることもできています。

・内部および外部構造の視覚化

オブジェクトの内部なども指定することで描くことができます。また外部構造についても同様です。(くるみの内部を描写することができています)

・コンテキストの詳細の推測

時間帯や季節に基づいて照明、影、環境を適応させることができます。特にキャプションが画像に明示的に記載されていない特定の詳細が含まれている必要があることを示唆している場合、「空白を埋める」ことができます。

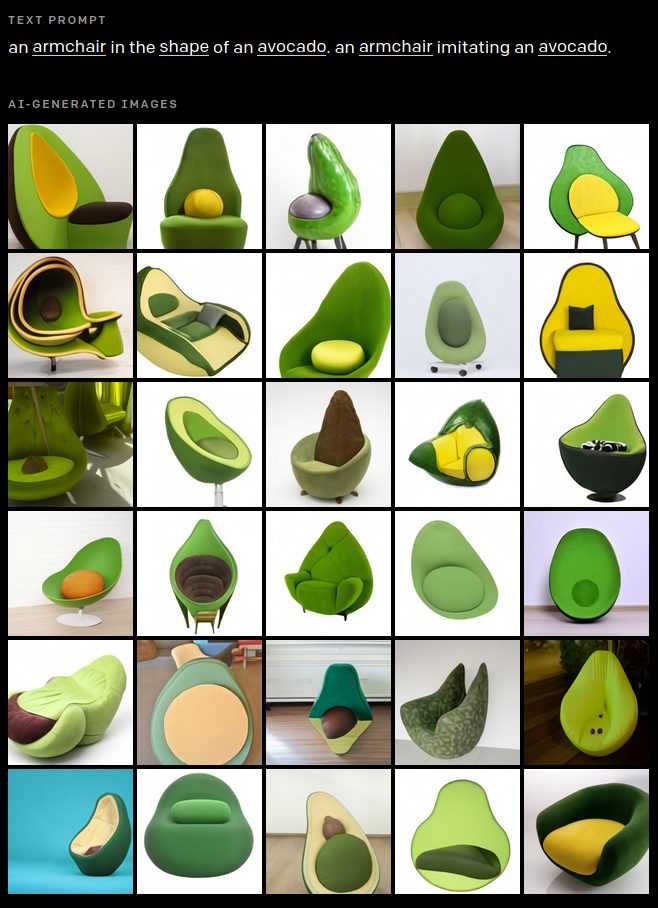

・無関係な概念の組み合わせ

関係ない概念同士もうまく組み合わせて描写できます。(アボカドと椅子の組み合わせもうまく表現しています)

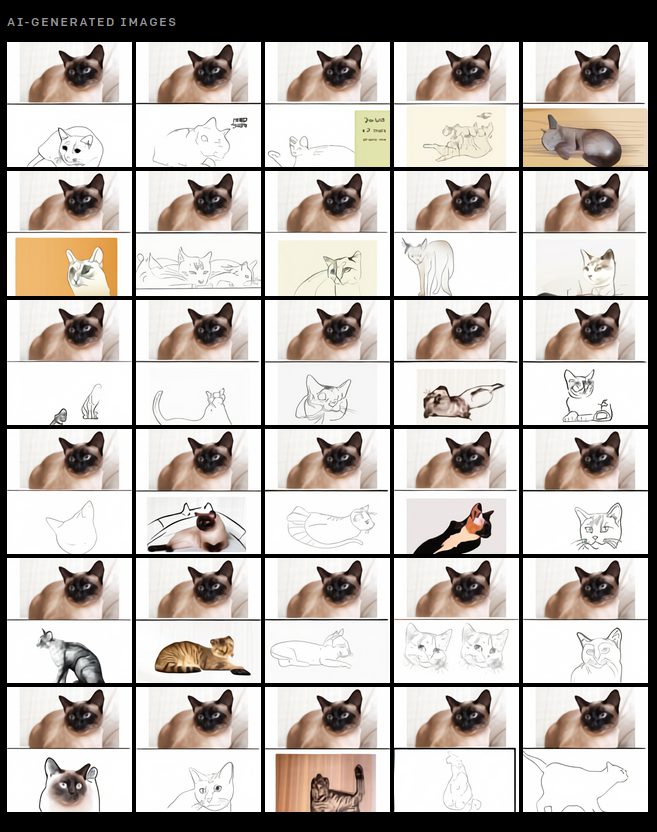

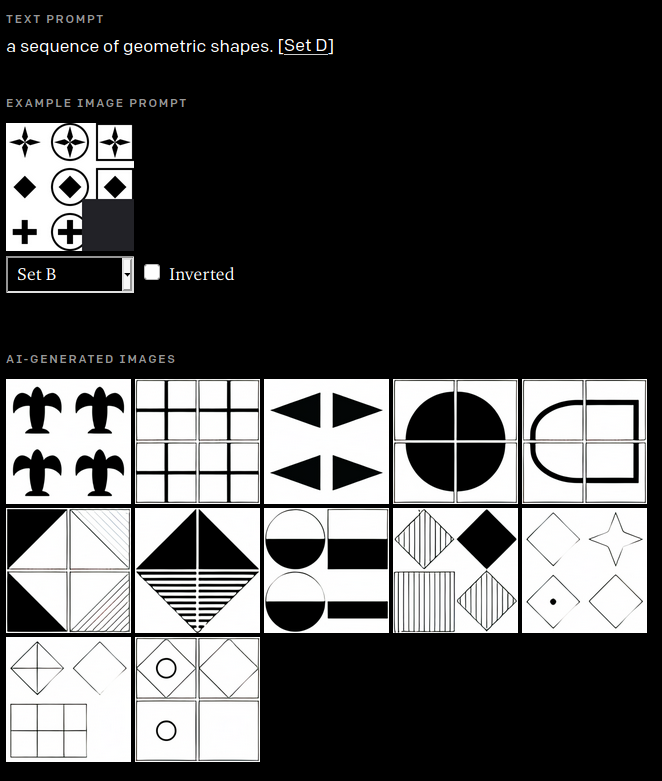

・ゼロショットの視覚的推論

追加学習せずに説明とキューから多くの種類のタスクを実行することができます。

また、視覚IQテストであるRavenのプログレッシブ行列でテストすることにより、類推の問題に対するDALL・Eの適性も測定されました。

・地理的知識

地理的知識も備えており、対応することができます。ただし、偏見といってもいいレベルの描写も多く、現実ほどの多様性は表現できていないとしています。(中華料理もイメージできるレベルで描写できています)

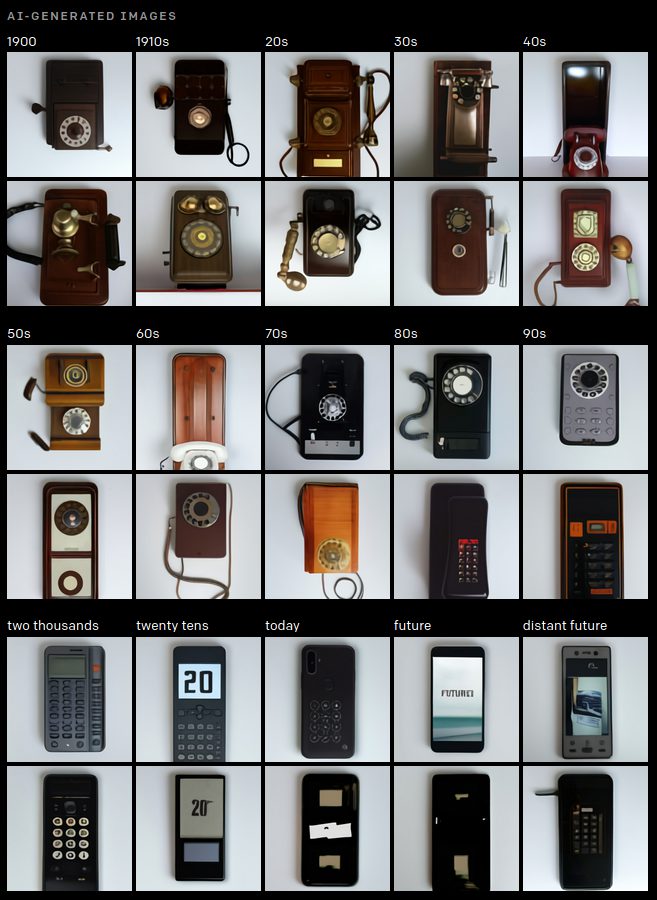

・時間的知識

時間的知識も備えており、指定した年代の変化を追うことができます。(年代にあわせた電話を描写できています。)

まとめ

DALL・Eは普通の表現から驚くほど的な画像を生成することができているように思えます。また、人間ではイメージしづらいものでもなんとなく生成することができるというのは今後強みになっていくようにおもえます。ただし、問題点も多く指摘されています。言い換えに脆弱であることや、指定オブジェクトごとに表現できるレベルに差があること、また明らかに偏見ともいえるような表現があるなど、まだまだ一般的に利用するには問題が多いようです。

しかし、生成力に関してはやはり驚嘆すべきものがあり、今後の動向が楽しみです。