はじめに

FacebookAIがより強力で柔軟な自己教師学習モデルSEERを発表しました。

『SEER: The start of a more powerful, flexible, and accessible era for computer vision』

https://ai.facebook.com/blog/seer-the-start-of-a-more-powerful-flexible-and-accessible-era-for-computer-vision/

●論文

『Self-supervised Pretraining of Visual Features in the Wild」

https://arxiv.org/pdf/2103.01988.pdf

●VISSL

(a computer VIsion library for state-of-the-art Self-Supervised Learning research with PyTorch)

PyTorchを使用した最先端の自己教師あり学習研究用のVIsionライブラリ

・公式HP

https://vissl.ai/

・GitHub

https://github.com/facebookresearch/vissl

概要・背景

現在のAIは、人間の手によってまとめられ、ラベルがつけられたデータを学習しています。しかし、この作業にはコストがかかり学習できるものも限定的であることから、理想的な形はより直接的なデータ(一般に手に入る普通の文章や画像)から学習できることです。

現在、自然言語処理分野では自己教師あり学習が成功し、性能の大幅な向上がもたらされています。今回、FAIRから画像分野での自己教師あり学習モデルが発表されました。

SEER:SElf-supERvised

FAIRがSEERを発表しました。SEERは、インターネット上の任意のランダムな画像グループから学習できる自己教師あり学習型の、10億ものパラメータをもつコンピュータビジョンモデルです。

SEERは、10億の①ランダムで、②ラベルがなく、③キュレーションされていないInstagram画像を事前トレーニングした後、最先端の自己教師あり学習モデルを上回るImageNetで84.2%のトップ1精度に達しました。SEERはまた、low-shot、物体検出、セグメンテーション、画像分類などのダウンストリームタスクで最先端の教師ありモデルを上回りました。ImageNetデータセットの例のわずか10%でトレーニングした場合でも、SEERは完全なデータセットでテストしたとき77.9%のトップ1精度を達成しました。またラベル付きのImageNetデータでわずか1%でトレーニングした場合でも、SEERは60.5%のトップ1精度を達成しました。

SEERのパフォーマンスは、自己教師あり学習が実際の環境でのコンピュータービジョンタスクに優れていることを示しているとしています。

SEER詳細

SEERを使用するための作業は、NLPで行われる自己教師あり学習の作業と類似しています。NLPの最先端のモデルでは、事前トレーニングのために数兆のテキストを含む数兆のパラメーターとデータセットが使用されています。より多くの入力とより大きなモデルにより、ダウンストリームタスクのパフォーマンスが劇的に向上しており、このことは同じことがコンピュータビジョンにも当てはまるはずという仮説から同様の作業が行われています。

自然言語処理の場合、最小単位の概念は基本的に単語となるため、あまり問題にはなりません。(英語の場合はスペースで区切られたトークンといえます。)しかし、画像の場合、アルゴリズムはどのピクセルがどの概念に属するかを決定する必要があります。またひとつのコンセプトのバリエーションを把握するためには、たくさんの画像を見る必要があります。

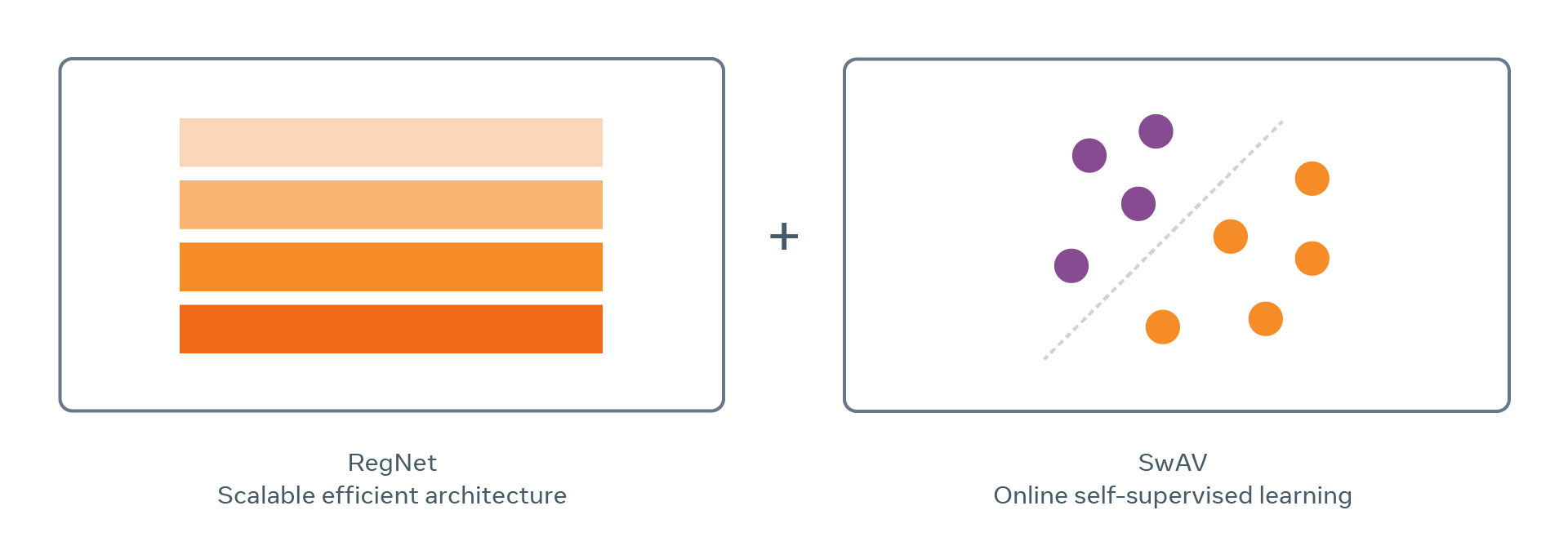

複雑な高次元画像データを効率的に処理するためにモデルを正常にスケーリングするために、2つのコンポーネントとひとつのライブラリが利用されています。

1)メタデータや注釈なしで膨大な数のランダム画像から学習できるアルゴリズム⇒SwAV

2)大きくて複雑なデータからすべての視覚的概念をキャプチャして学習するのに十分な大きさの畳み込みネットワーク(ConvNet)⇒RegNet

SwAV

SwAVは、FAIRによって開発された自己教師あり学習用のアルゴリズムです。SwAVは、オンラインクラスタリングを使用して、類似した視覚的概念を持つ画像を迅速にグループ化し、それらの類似性を活用します。自己教師あり学習で従来の最高精度を更新することができました。また、トレーニング時間が6分の1に短縮されています。

RegNet

この規模でモデルをトレーニングするには、精度を犠牲にすることなく、ランタイムとメモリの両方の点で効率的なモデルアーキテクチャも必要でした。RegNetモデルは、数十億または場合によっては数兆のパラメーターに拡張できるConvNetであり、さまざまなランタイムおよびメモリの制限に合わせて最適化できます。

VISSL

SEERを可能にする自己教師あり学習用の多目的ライブラリの開発が行われています。VISSLには、広範なベンチマークスイートと、60を超える事前トレーニング済みモデルで構成されるモデル群も含まれているため、研究者はいくつかの最新の自己教師あり手法を比較することが可能になっています。VISSLは、GPUごとのメモリ要件を削減し、特定のモデルのトレーニング速度を向上させるいくつかの既存のアルゴリズムを統合することにより、大規模な自己教師あり学習を容易にします。

まとめ

自然言語処理分野は自己教師あり学習をすることが可能になってから飛躍的に性能が向上し、大量のデータを利用することが可能になりました。今後、画像分野でも自己教師あり学習が可能になることで大幅な性能が期待されています。現在の自己教師あり学習については、Yann LuCan氏がSEERの発表とあわせて解説されており、その解説をまとめた記事も掲載していますので、ご興味がある方はご確認ください。

『Yann LuCan氏による近年の自己教師あり学習についての解説をまとめました』

https://deepsquare.jp/2021/03/yann-lucan-self-supervised-learning/